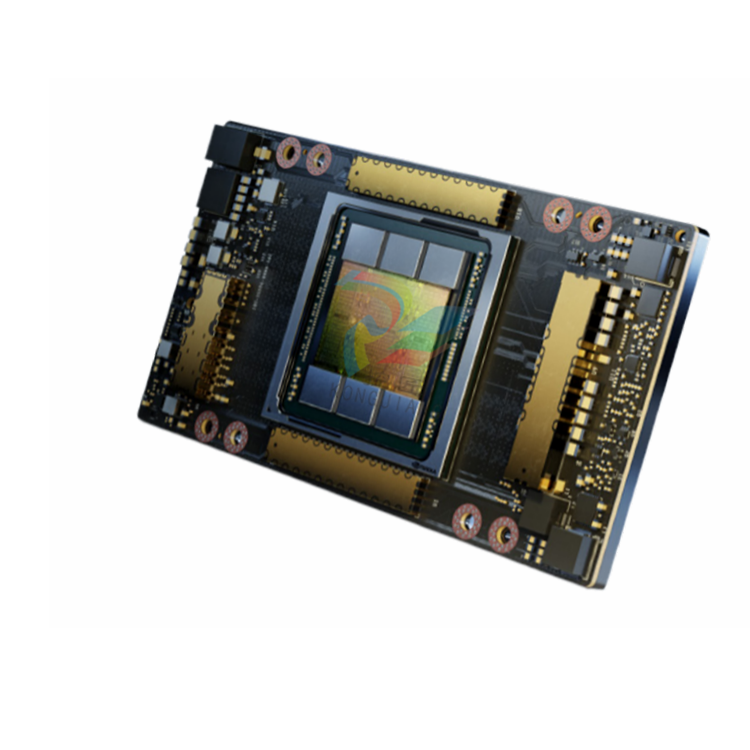

NVIDIA A100 张量核心处理器

描述

英伟达™(NVIDIA®)A100 Tensor Core GPU可在各种规模上提供前所未有的加速性能,为全球最高性能的弹性数据中心提供动力,适用于人工智能、数据分析和高性能计算(HPC)应用。作为英伟达™(NVIDIA®)数据中心平台的引擎,A100的性能比上一代英伟达™(NVIDIA®)Volta™处理器提高了20倍。A100 可以高效地扩展,也可以利用多实例 GPU(MIG)将其划分为七个独立的 GPU 实例,从而提供一个统一的平台,使弹性数据中心能够动态调整以适应不断变化的工作负载需求。

英伟达™(NVIDIA®)A100 Tensor Core技术可支持多种数学精度,为各种工作负载提供单一加速器。最新一代的A100 80GB将GPU内存增加了一倍,并首次以每秒2太字节(TB/s)的速度提供了世界上最快的内存带宽,加快了最大模型和最大规模数据集的解决速度。

突破性创新

英伟达安培架构

无论是使用 MIG 将 A100 GPU 划分为较小的实例,还是使用 NVLink 连接多个 GPU 以加速大型工作负载,A100 都能轻松处理不同规模的加速需求,从最小的作业到最大的多节点工作负载。A100 的多功能性意味着 IT 经理可以全天候最大限度地利用数据中心的每个 GPU。

第三代张量内核

NVIDIA A100 可提供 312 teraFLOPS (TFLOPS) 的深度学习性能。与英伟达 Volta GPU 相比,深度学习训练的 Tensor 浮点运算每秒 (FLOPS) 是后者的 20 倍,深度学习推理的 Tensor 太拉运算每秒 (TOPS) 是后者的 20 倍。

下一代 NVLink

A100 中的 NVIDIA NVLink 与上一代产品相比,吞吐量提高了 2 倍。与英伟达™(NVIDIA®)NVSwitch™结合使用时,最多可将16个A100 GPU以每秒600GB的速度互连起来,从而在单个服务器上释放出最高的应用性能。NVLink 可通过 HGX A100 服务器板在 A100 SXM GPU 中使用,也可通过 NVLink Bridge 在 PCIe GPU 中使用,最多可连接 2 个 GPU。

多实例 GPU(MIG)

一个 A100 GPU 可划分为多达 7 个 GPU 实例,这些实例在硬件层面完全隔离,拥有各自的高带宽内存、高速缓存和计算内核。MIG 可为开发人员的所有应用提供突破性的加速,IT 管理员可为每项工作提供适当大小的 GPU 加速,优化利用率,并扩大对每个用户和应用的访问。

高带宽内存(HBM2E)

凭借高达 80 千兆字节的 HBM2e,A100 可提供超过 2TB/s 的全球最快 GPU 内存带宽,以及 95% 的动态随机存取内存 (DRAM) 利用效率。与上一代产品相比,A100 的内存带宽提高了 1.7 倍。

参数

FP64:9.7 TFLOPS

FP64 张量核:19.5 TFLOPS

FP32:19.5 TFLOPS

张量浮点运算 32 (TF32):156 TFLOPS | 312 TFLOPS

BFLOAT16 张量核心:312 TFLOPS | 624 TFLOPS

FP16 张量核心:312 TFLOPS | 624 TFLOPS